Hadoop学习——Sqoop入门与实战

Hadoop学习——Sqoop入门与实战

前言

Hadoop作为一个开源的分布式计算框架,在大数据处理领域具有举足轻重的地位。而Sqoop作为Hadoop生态圈中的一个重要组件,主要致力于实现关系型数据库与Hadoop之间的数据迁移。今天,我们将通过这篇博客,带领大家从零开始学习Sqoop,并掌握如何利用它进行高效的数据迁移。

一、Sqoop简介

在正式开始学习之前,让我们先简单了解一下Sqoop。Sqoop是一个用于在Hadoop和关系数据库之间传输数据的工具。它支持将数据从关系数据库(如MySQL、Oracle等)导入到HDFS,同时也可以将数据从HDFS导出到关系数据库。Sqoop利用了Hadoop的MapReduce模型来实现高效的数据迁移,并支持多种文件格式,如文本文件、SequenceFile等。

二、环境准备

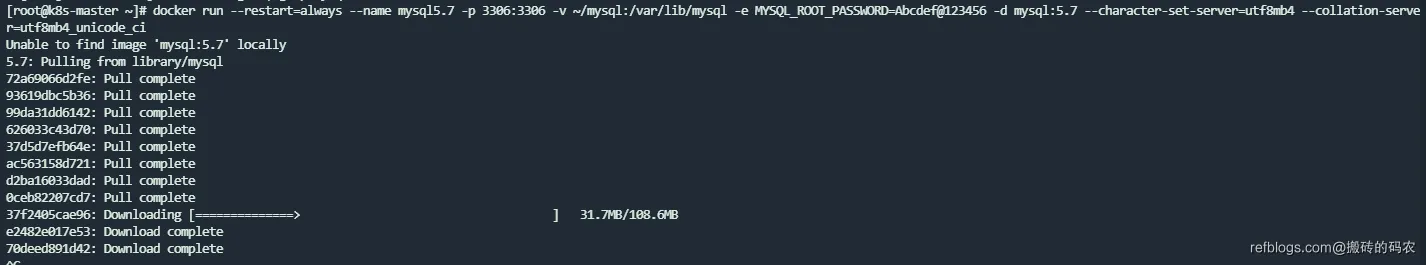

在学习Sqoop之前,我们需要准备以下环境:

- Hadoop集群:确保Hadoop集群已安装并正常运行。

- MySQL数据库:安装MySQL数据库,并创建测试数据库和表。

- Sqoop安装:下载并安装Sqoop。

三、实战操作

3.1 数据导入

3.1.1 创建测试数据库和表

首先,我们使用MySQL创建一个名为sqooptest的数据库,并创建一个名为emp的表。

CREATE DATABASE sqooptest;

USE sqooptest;

CREATE TABLE emp (

EMPNO INT PRIMARY KEY,

ENAME VARCHAR(50),

JOB VARCHAR(50)

);

3.1.2 使用Sqoop导入数据

接下来,我们使用Sqoop将MySQL中的数据导入到HDFS。

sqoop import \

--connect jdbc:mysql://localhost:3306/sqooptest \

--username root \

--password root \

--table emp \

--target-dir /user/sqoop/emp \

--split-by EMPNO \

--fields-terminated-by ','

这里,我们指定了数据库的连接信息、用户名、密码、表名、目标目录、拆分列和字段分隔符。

3.1.3 查看导入的数据

导入完成后,我们可以使用Hadoop的命令行工具查看导入的数据。

hadoop fs -cat /user/sqoop/emp/*

3.2 数据导出

3.2.1 使用Sqoop导出数据

接下来,我们将HDFS中的数据导出到MySQL数据库。

sqoop export \

--connect jdbc:mysql://localhost:3306/sqooptest \

--username root \

--password root \

--table emp \

--export-dir /user/sqoop/emp \

--input-fields-terminated-by ','

3.2.2 查看导出的数据

导出完成后,我们可以使用MySQL的命令行工具查看导出的数据。

SELECT * FROM emp;

四、注意事项

- 在导入数据前,确保MySQL表已创建。

- 字段之间的分隔符可以自定义。

- 导出时MySQL表的字段数与HDFS上的列数可以不相同。

- 处理带有主键约束的表导出时,需注意数据冲突。

五、最佳实践

- 在使用Sqoop进行数据迁移时,合理配置MapReduce任务的数量,以提高迁移效率。

- 根据实际需求,选择合适的文件格式进行数据存储。

- 定期检查Hadoop集群和MySQL数据库的性能,确保数据迁移的稳定性。

六、总结

通过本篇博客,我们了解了Sqoop的基本概念、环境准备和实战操作。通过实战演练,我们掌握了如何使用Sqoop进行数据导入和导出。希望这篇博客能帮助大家更好地理解和运用Sqoop,实现高效的数据迁移。

正文到此结束

相关文章

热门推荐

评论插件初始化中...