Java Playwright 爬虫实战:从零掌握动态网站数据抓取

- 发布时间:2025-12-29 20:56:26

- 本文热度:浏览 355 赞 0 评论 0

- 文章标签: Playwright Java 爬虫

- 全文共1字,阅读约需1分钟

🚀 Playwright 深度实战:Java全栈工程师的高效爬虫利器(面向小白,从0到生产级应用)

💡 基础概念与核心思想:为什么需要“模拟浏览器”?

什么是传统爬虫的局限?

传统的爬虫技术,例如使用 HttpClient 或 Jsoup,主要依赖于发送 HTTP 请求并解析返回的 HTML 字符串。

- 局限性: 现代网页大量使用 JavaScript 进行动态渲染。当你请求一个页面时,服务器返回的可能只是一个骨架 HTML(如一个空的

<div>),真正的内容是在浏览器加载后,通过执行 JavaScript 脚本,向后端 API 发送请求并填充到 DOM 结构中的。 - 结果: 传统爬虫拿到的 HTML 源码,看不到任何动态加载的数据,也就无法进行抓取。

什么是 Playwright?

Playwright 是一个由 Microsoft 开发的开源 Node.js 库,用于端到端(End-to-End)测试和自动化。它支持 Chromium (Google Chrome), Firefox, 和 WebKit (Safari) 三大主流浏览器内核,并且提供了多语言绑定,包括 Java、Python、.NET 等。

在爬虫领域,我们利用 Playwright 的自动化能力:

- 它启动一个真实的浏览器实例(无头模式或有头模式)。

- 它像用户一样操作浏览器(点击、输入、滚动、等待)。

- 它能执行页面上的 所有 JavaScript,确保页面完全渲染,从而获取到最真实、最完整的 DOM 结构和数据。

Playwright 的核心优势

| 特性 | 传统爬虫(HttpClient/Jsoup) | Playwright (浏览器自动化) |

|---|---|---|

| JS 动态渲染 | ❌ 无法处理或处理复杂 | ✅ 完全支持,所见即所得 |

| 反爬虫检测 | 易被识别(无指纹) | 强(可模拟真实用户指纹) |

| 操作复杂性 | 仅限于 HTTP 交互 | 支持点击、输入、拖拽等复杂操作 |

| 性能开销 | 低(仅网络请求) | 较高(需启动浏览器进程) |

🛠️ 工作原理与底层机制:Playwright 如何与浏览器通信?

架构总览:Client-Server-Browser

Playwright 的核心机制是基于其跨语言/跨进程的通信协议。

- Playwright Java Client: 我们的 Java 代码通过其 API 调用,例如

page.navigate(url)。 - Playwright Driver: 这是一个独立的进程,它负责接收 Java 端的指令,并将其翻译成浏览器可以理解的底层协议(如 DevTools Protocol)。

- Browser Process: 驱动程序通过协议与真实的浏览器实例(Chromium, Firefox, WebKit)进行通信和控制。

【伪图示】Playwright 工作流

[Java 应用] --(API 调用)--> [Playwright Java Client] --(IPC/WebSocket)--> [Playwright Driver (Node.js/Go)] --(DevTools Protocol)--> [真实浏览器]

关键点:无头 (Headless) 模式

在爬虫场景中,我们通常使用无头模式。这意味着浏览器在后台运行,你看不到它的图形界面(GUI)。这大大节省了系统资源,提高了爬取效率。Playwright 默认即为无头模式,可以通过配置轻松切换到有头模式进行调试。

⚙️ 环境准备:从零搭建 Java + Playwright 项目

作为一名 Java 工程师,我们通常使用 Maven 或 Gradle 管理项目。

1. 创建 Maven 项目

使用 IDE(如 IntelliJ IDEA)创建一个新的 Maven 项目。

2. 引入 Playwright 依赖

在 pom.xml 文件中,添加 Playwright 依赖。

<dependencies>

<dependency>

<groupId>com.microsoft.playwright</groupId>

<artifactId>playwright</artifactId>

<version>1.40.0</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-simple</artifactId>

<version>2.0.7</version>

</dependency>

<dependency>

<groupId>org.junit.jupiter</groupId>

<artifactId>junit-jupiter-api</artifactId>

<version>5.10.1</version>

<scope>test</scope>

</dependency>

</dependencies>

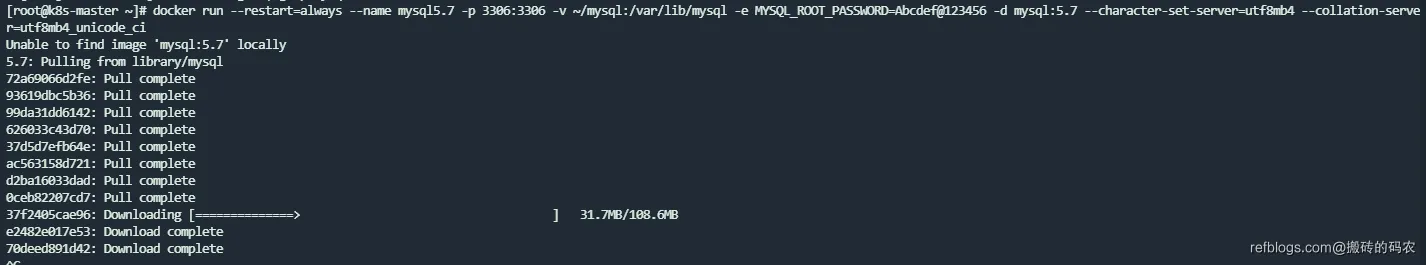

注意版本: 这里的版本号 (如 1.40.0) 应使用最新的稳定版本。首次运行时,Playwright 会自动下载所需的浏览器驱动器和二进制文件,无需手动安装。

3. 首次运行与浏览器安装

当你第一次运行 Playwright 代码时,如果本地没有对应的浏览器二进制文件,Playwright 会尝试执行一个安装脚本。

你也可以手动执行安装命令(在项目根目录下):

# Playwright 会检查 Java/Python/Node.js 等环境,

# 并下载对应的浏览器(Chromium, Firefox, WebKit)

mvn compile exec:java -D exec.mainClass=com.microsoft.playwright.CLI -D exec.args=install

执行成功后,你会在用户目录下看到一个 .m2 目录之外的 Playwright 缓存目录,里面存放着浏览器文件。

💻 运行示例代码:Playwright 的 Hello World

这个示例展示了如何启动浏览器、访问一个动态渲染的页面、等待内容加载,并获取页面标题和内容。

Java 代码:PlaywrightBasicScraper.java

import com.microsoft.playwright.*;

import com.microsoft.playwright.options.WaitUntilState;

public class PlaywrightBasicScraper {

public static void main(String[] args) {

// 1. 初始化 Playwright 运行时环境

try (Playwright playwright = Playwright.create()) {

// 2. 启动浏览器(这里使用 Chromium)

// Headless(无头模式) 默认为 true,生产环境推荐

Browser browser = playwright.chromium().launch(new BrowserType.LaunchOptions()

.setHeadless(true)

// 调试时可以设置 setHeadless(false)

);

// 3. 创建一个新的浏览器上下文 (Context)

// Context 允许隔离 Cookies、LocalStorage 等数据

BrowserContext context = browser.newContext();

// 4. 创建一个页面 (Page)

Page page = context.newPage();

// 5. 导航到目标 URL,等待网络空闲 (networkidle) 状态,确保动态内容加载完成

String targetUrl = "https://example.com"; // 替换为你的目标 URL

System.out.println("-> 正在访问: " + targetUrl);

page.navigate(targetUrl, new Page.NavigateOptions()

.setWaitUntil(WaitUntilState.NETWORKIDLE));

// 6. 核心爬取操作

String title = page.title();

System.out.println("✅ 页面标题: " + title);

// 获取整个页面的 HTML 内容(包含 JS 渲染后的结果)

String content = page.content();

// System.out.println("页面内容 (部分): \n" + content.substring(0, 500) + "...");

// 7. 使用 CSS 选择器定位元素并获取文本

// 假设我们要获取一个 ID 为 "main-content" 的 div 的文本

Locator mainContent = page.locator("#main-content");

if (mainContent.isVisible()) {

String text = mainContent.innerText();

System.out.println("📝 主内容文本(Playwright 获取): " + text.trim());

} else {

System.out.println("⚠️ 未找到 #main-content 元素或其不可见。");

// 实际爬虫中,这里可能需要更复杂的等待机制

}

// 8. 关闭浏览器

browser.close();

} catch (PlaywrightException e) {

System.err.println("Playwright 操作失败: " + e.getMessage());

e.printStackTrace();

}

}

}

🕷️ 实战案例:抓取分页列表数据与表单交互

本案例模拟抓取一个假想的电子商务网站上的商品列表,并涉及点击分页按钮的实战技巧。

1. 明确目标和流程

- 打开商品列表首页。

- 定位到列表中的每个商品项。

- 提取商品名称、价格等信息。

- 找到“下一页”按钮并点击。

- 重复步骤 2-4,直到没有下一页。

2. 定位器 (Locator) 的艺术

Playwright 推荐使用 Locator API 来进行元素定位,它具有自动等待元素出现的能力,比传统的 page.querySelector() 更稳定可靠。

| 策略 | 示例 | 场景 |

|---|---|---|

| CSS 选择器 | page.locator(".product-card h2") |

最常用,高效 |

| XPath | page.locator("//div[@class='item'][2]") |

复杂层级或回溯定位 |

| Text | page.locator("text=下一页") |

基于文本内容定位 |

| Role (ARIA) | page.locator("role=button[name='提交']") |

提升可访问性和稳定性 |

3. 核心 Java 代码实现:分页爬取

import com.microsoft.playwright.*;

import java.util.List;

public class PaginationScraper {

// 内部类用于存储商品数据

static class Product {

String name;

String price;

// ... 其他字段

@Override

public String toString() {

return String.format("Product{name='%s', price='%s'}", name, price);

}

}

public static void main(String[] args) {

// ... 初始化 Playwright, Browser, Context, Page (同上略) ...

try (Playwright playwright = Playwright.create()) {

Browser browser = playwright.chromium().launch();

Page page = browser.newPage();

String baseUrl = "https://fictional-shop.com/products?page=1"; // 假设的起始 URL

page.navigate(baseUrl);

boolean hasNextPage = true;

int pageNum = 1;

while (hasNextPage) {

System.out.println("\n--- 正在抓取第 " + pageNum + " 页数据 ---");

// **等待关键元素加载**

// 确保列表容器已出现在 DOM 中,Playwright 会自动等待

Locator productList = page.locator(".product-list-container");

productList.waitFor(); // 确保容器可见

// **定位所有商品卡片**

List<Locator> productCards = productList.locator(".product-card").all();

for (Locator card : productCards) {

// 提取数据

// 链式调用:在 card 的作用域内查找 h2 标题

String name = card.locator("h2.product-name").innerText();

String price = card.locator(".product-price").innerText();

Product product = new Product();

product.name = name.trim();

product.price = price.trim();

System.out.println(product);

}

// **处理分页逻辑**

Locator nextPageButton = page.locator("text=下一页");

// 检查按钮是否可用(避免死循环)

if (nextPageButton.isVisible() && nextPageButton.isEnabled()) {

System.out.println("-> 发现下一页,点击继续...");

// **点击操作**

// Playwright 的 click() 方法会自动滚动到元素位置并等待点击生效

nextPageButton.click();

// **重要:等待页面导航或数据刷新**

// 方式一:等待 URL 变化

// page.waitForURL("**/products?page=" + (pageNum + 1));

// 方式二:等待列表容器再次刷新(数据变化,URL不变时常用)

// 实际项目中需要根据网站特性选择最合适的等待方式

page.waitForLoadState(WaitUntilState.NETWORKIDLE); // 等待网络空闲

pageNum++;

} else {

hasNextPage = false;

System.out.println("--- 所有页面抓取完毕 ---");

}

}

browser.close();

} catch (PlaywrightException e) {

System.err.println("爬取过程中发生错误: " + e.getMessage());

}

}

}

🛡️ 高级用法与反爬虫策略

1. 设置用户代理 (User Agent)

网站经常通过 User Agent 来识别是否为机器人。Playwright 允许我们在创建 BrowserContext 时设置一个真实的 User Agent。

// ...

BrowserContext context = browser.newContext(new Browser.NewContextOptions()

// 模拟一个真实的 Chrome 浏览器 User-Agent

.setUserAgent("Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36")

// 可选:设置 Viewport 以模拟桌面分辨率

.setViewportSize(1920, 1080)

);

Page page = context.newPage();

// ...

2. 处理 Cookies 和 LocalStorage

登录爬取或保持会话状态是常见的需求。

保存会话状态:

// 登录操作完成后

context.storageState(new BrowserContext.StorageStateOptions().setPath(Paths.get("auth.json")));

加载会话状态:

// 下次运行时加载已保存的 Cookies/LocalStorage

BrowserContext context = browser.newContext(new Browser.NewContextOptions()

.setStorageStatePath(Paths.get("auth.json"))

);

Page page = context.newPage();

3. 拦截请求 (Request Interception)

Playwright 允许你在网络请求发送之前进行拦截、修改或阻止。这在爬虫中有两大用途:

- 性能优化: 阻止图片、字体、视频等大文件的加载,只加载 HTML/CSS/JS,节省带宽和时间。

- API 抓取: 如果页面是通过 AJAX 调用 API 来填充数据的,你可以拦截这个 API 请求,直接获取 JSON 数据,比解析 DOM 更高效。

// 1. 阻止图片和字体的加载

page.route("**/*", route -> {

String resourceType = route.request().resourceType();

if ("image".equals(resourceType) || "font".equals(resourceType)) {

route.abort(); // 阻止请求

} else {

route.resume(); // 允许请求继续

}

});

// 2. 拦截并监听特定的 API 请求

page.route("**/api/products/list**", route -> {

// 允许请求继续

route.resume();

});

// 在请求完成后监听响应

page.onResponse(response -> {

if (response.url().contains("api/products/list")) {

System.out.println("成功抓取到 API 响应,URL: " + response.url());

// 可以读取响应体: response.text().thenAccept(json -> { ... 处理 json ... });

}

});

page.navigate(targetUrl);

⚠️ 常见错误及排查方法

| 错误类型 | 错误描述 | 排查思路与解决方案 |

|---|---|---|

| Element Not Found | TimeoutError: waiting for selector "..." failed |

最常见。页面元素尚未加载完成或选择器写错。使用 page.waitForSelector() 或 locator.waitFor(),并增加等待时间。检查选择器是否在浏览器控制台(Console)中能正确匹配。 |

| Headless 失败 | 启动浏览器时报错,如 Browser closed unexpectedly |

可能是 Linux 环境缺少依赖库(如 libnss3)。尝试先在有头模式 (setHeadless(false)) 调试。在服务器上确保环境依赖安装完整。 |

| 反爬虫封禁 | 页面返回 403 错误或验证码 (CAPTCHA) | 设置真实 User Agent、Viewport。使用 page.context().setExtraHTTPHeaders() 增加自定义 Header。引入代理 IP 池。 |

| 内存溢出 | 长时间运行后 JVM 内存泄漏 (OOM) | 每次爬取完成后,确保关闭 page、browser 和最外层的 playwright 实例(使用 try-with-resources 或显式调用 close())。批量爬取时,定期重启 BrowserContext 以释放资源。 |

⭐ 最佳实践与经验总结:生产级爬虫的要素

- 资源管理(Context 隔离): 每次抓取任务使用一个新的

BrowserContext。这可以隔离 Cookies、缓存、Local Storage,避免一次任务失败污染整个浏览器实例,同时有助于防止网站通过 Cookies 追踪你的爬虫行为。 - 优雅等待 (Smart Waiting): 尽量避免使用硬编码的

Thread.sleep()。优先使用 Playwright 提供的等待机制:locator.waitFor()page.waitForLoadState(WaitUntilState.NETWORKIDLE)page.waitForSelector(selector, new Page.WaitForSelectorOptions().setState(State.VISIBLE))

- 日志记录 (Logging): 详细记录每次请求、响应、成功提取的数据条数和遇到的错误,方便后续排查和监控。配合 SLF4J + Logback 等成熟日志框架。

- 异常处理与重试: 任何网络操作都可能失败。对

page.navigate()和locator.click()等关键操作设置重试机制。例如,失败后等待 5 秒,最多重试 3 次。 - 分布式与限速: 在生产环境中,你需要将 Playwright 爬虫包装成一个服务,并通过 Redis 队列 或 消息中间件 (如 Kafka) 实现分布式调度。严格控制对目标网站的访问频率(如每秒请求数),避免对目标服务器造成过大压力,这也是最基本的爬虫道德。可以使用 Java 的

RateLimiter(如 Guava 的实现)进行限速。