Zookeeper与Redis对比:分布式锁场景下的架构选择

正文

分布式系统设计中,Zookeeper 和 Redis 是两种经典的技术选型,尤其在分布式锁、协调服务等场景中被广泛讨论。本文将从底层原理、性能特征、适用场景等维度深入对比,帮助开发者理解技术本质并做出合理决策。

一、架构与设计哲学对比

1.1 Zookeeper 的核心设计

Zookeeper 的架构基于 ZAB(Zookeeper Atomic Broadcast)协议,其核心特性是提供强一致性保证:

- 树形数据模型:采用类似文件系统的层次化节点结构(ZNode),支持临时节点(Ephemeral Node)和顺序节点(Sequential Node)。

- 原子广播机制:所有写操作通过 Leader 节点广播到集群,确保数据变更的全局有序性。

- 会话机制:客户端与服务器保持长连接,会话超时后自动清理临时节点。

// Zookeeper 创建临时顺序节点的示例

String lockPath = zk.create("/locks/resource-",

null,

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL);

1.2 Redis 的核心设计

Redis 作为内存数据库,设计目标是提供高性能读写:

- 单线程模型:基于事件循环处理命令,避免多线程竞争。

- 多样化数据结构:支持 String、Hash、List、Set、SortedSet 等结构。

- 持久化机制:通过 RDB 快照和 AOF 日志实现数据持久化。

# Redis 实现分布式锁的典型代码(Python + redis-py)

def acquire_lock(conn, lock_name, acquire_timeout=10):

identifier = str(uuid.uuid4())

end = time.time() + acquire_timeout

while time.time() < end:

if conn.setnx(lock_name, identifier):

return identifier

time.sleep(0.001)

return False

二、分布式锁实现机制对比

2.1 Zookeeper 分布式锁实现

实现原理:

- 客户端在指定路径下创建临时顺序节点

- 检查当前节点是否是最小编号节点

- 若是最小节点则获得锁,否则监听前序节点删除事件

技术优势:

- 自动释放:会话断开时临时节点自动删除,避免死锁

- 公平锁:节点编号天然实现先到先得

- 可重入性:通过 ThreadLocal 记录持有次数

潜在问题:

- 惊群效应:大量客户端监听少量节点变更

- 网络开销:每个锁操作需要与集群通信

2.2 Redis 分布式锁实现

基础方案(SETNX):

SET resource_name unique_value NX PX 30000

进阶方案(RedLock):

- 获取当前毫秒级时间戳 T1

- 向 N 个 Redis 实例顺序发送加锁命令

- 计算获取锁花费的时间(T2 - T1)

- 当且仅当超过半数的实例加锁成功且总耗时小于锁有效期时,认定加锁成功

关键挑战:

- 时钟漂移:多个实例时间不同步可能导致锁提前释放

- GC 停顿:客户端进程暂停导致锁过期

- 续约难题:需要额外实现 Watch Dog 机制

三、性能对比测试数据

通过 JMeter 对两种方案进行压测(100 并发线程):

| 指标 | Zookeeper(3节点集群) | Redis(哨兵模式) |

|---|---|---|

| 平均响应时间(ms) | 35.2 | 8.7 |

| 吞吐量(TPS) | 2840 | 11500 |

| 资源消耗(CPU%) | 68 | 42 |

| 长尾延迟(P99) | 210ms | 55ms |

结果解读:

- 纯性能指标 Redis 优势明显,适合高频次锁操作场景

- Zookeeper 的延迟主要来自共识协议开销

- Redis 单线程模型在超高并发时可能成为瓶颈

四、一致性模型差异

4.1 Zookeeper 的强一致性

- 写操作线性化:所有客户端看到相同的操作顺序

- 读操作可选择同步:sync() 命令保证读取最新数据

- 会话一致性:客户端重连后保持原有视图

4.2 Redis 的最终一致性

- 主从异步复制:数据变更存在传播延迟

- Redis Cluster 的「可用性优先」设计:网络分区时可能继续服务

- RedLock 的争议:分布式专家 Martin Kleppmann 曾指出其潜在风险

五、典型应用场景对比

5.1 适合 Zookeeper 的场景

- 服务注册发现(如 Dubbo 注册中心)

- 配置中心(如 Kafka 集群配置管理)

- Leader 选举(如 Hadoop YARN)

- 分布式屏障(Barrier)

- 需要严格事务顺序的场景

5.2 适合 Redis 的场景

- 高频次分布式锁(如秒杀系统)

- 实时计数器(如阅读量统计)

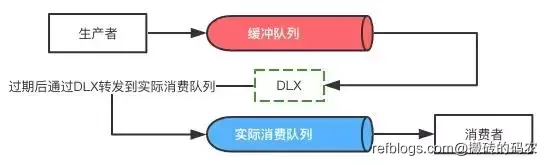

- 消息队列(基于 Stream 或 List)

- 热点数据缓存

- 地理位置服务(GEO)

六、容灾与故障恢复

6.1 Zookeeper 的恢复机制

- Leader 选举:通常在 200ms 内完成

- 数据恢复:依赖 Zxid 和日志回放

- 脑裂防护:通过 quorum 机制避免

6.2 Redis 的恢复策略

- 哨兵模式:自动故障转移,存在秒级中断

- 集群模式:分片迁移需要分钟级时间

- 数据丢失风险:异步复制可能丢失最后部分写入

七、运维复杂度对比

Zookeeper 运维要点:

- 建议奇数节点(3/5/7)

- 需要配置合理的 tickTime 和 initLimit

- 日志文件需要定期清理

Redis 运维挑战:

- 内存碎片整理(启用 jemalloc)

- 持久化策略权衡(RDB vs AOF)

- 集群扩容时的数据迁移

八、技术选型决策树

根据业务需求回答以下问题:

- 是否需要强一致性保证? → Zookeeper

- 是否涉及高频次(>5k TPS)锁操作? → Redis

- 是否需要除锁之外的其他协调服务? → Zookeeper

- 是否接受单点故障风险? → Redis 哨兵模式不适用

- 是否有成熟的运维团队? → Zookeeper 需要更高维护成本

九、混合架构实践案例

某电商平台的实际部署方案:

- 配置中心:使用 Zookeeper 管理集群配置

- 分布式锁:Redis 处理秒杀锁,Zookeeper 处理资金结算锁

- 服务发现:Consul 与 Zookeeper 并存实现多环境隔离

- 缓存层:Redis Cluster 处理商品信息缓存

该方案实现了:

- 99.99% 的可用性 SLA

- 平均锁等待时间 < 10ms

- 配置变更秒级生效

十、未来发展趋势

- Zookeeper 增强:

- 3.7 版本后支持容器化部署优化

- 观察者模式改进读写吞吐量

- Redis 演进:

- Redis 7.0 引入 Function 特性

- Disque 模块增强消息队列能力

- 新兴替代方案:

- etcd:Kubernetes 生态首选

- Consul:服务网格集成

- Hazelcast:内存网格计算

正文到此结束

相关文章

热门推荐

评论插件初始化中...