数据库主键冲突错误Duplicate entry的解决方案

当我们面对"Duplicate entry for key 'PRIMARY'"这个刺眼的错误提示时,很多开发者都会心头一紧。这个看似简单的数据库错误背后,隐藏着系统设计中诸多关键考量。本文将深入探讨主键冲突的本质原因,并提供一套完整的解决方案体系。

一、错误发生的深层逻辑

主键重复错误(Error Code: 1062)的本质是关系型数据库对数据完整性的强制保护。主键作为记录的唯一标识符,其唯一性约束由数据库引擎在多个层面进行校验:

-

存储引擎层校验(InnoDB为例)

- B+树索引结构自动维护键值唯一性

- 插入前检查聚簇索引叶节点

- 内存中的Change Buffer异步校验

-

SQL解析层校验

-- 即使绕过应用层检查,数据库仍会最终校验 INSERT INTO users (id, name) VALUES (1, 'Alice'); -

事务隔离级别影响

-- RR隔离级别下可能出现幻读导致的重复 START TRANSACTION; SELECT * FROM users WHERE id = 2 FOR UPDATE; -- 此时其他事务插入id=2的记录会导致当前事务提交失败

二、典型场景与解决方案矩阵

场景1:简单插入冲突

-- 经典错误重现

CREATE TABLE products (

sku VARCHAR(10) PRIMARY KEY,

name VARCHAR(50)

);

INSERT INTO products VALUES ('A100', 'Phone');

INSERT INTO products VALUES ('A100', 'Tablet'); -- 触发错误

解决方案对比表

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| INSERT IGNORE | 简单快速 | 会忽略所有错误 | 批量导入非关键数据 |

| ON DUPLICATE UPDATE | 可更新其他字段 | 可能产生死锁 | 需要更新统计字段 |

| REPLACE INTO | 保证数据最新 | 实际是删除+插入操作 | 需要强制覆盖记录 |

| 事务+SELECT检查 | 完全控制流程 | 增加两次查询开销 | 高并发敏感场景 |

场景2:批量插入中的部分冲突

# Python示例:批量插入处理

import mysql.connector

from mysql.connector import Error

try:

conn = mysql.connector.connect(...)

cursor = conn.cursor()

batch_data = [

(101, 'Widget A'),

(102, 'Widget B'),

(101, 'Widget C') # 重复主键

]

# 方案1:使用INSERT IGNORE

sql = "INSERT IGNORE INTO products (id, name) VALUES (%s, %s)"

cursor.executemany(sql, batch_data)

# 方案2:捕获异常逐条处理

for item in batch_data:

try:

cursor.execute("INSERT INTO products VALUES (%s, %s)", item)

except mysql.connector.IntegrityError as e:

print(f"跳过重复条目 {item[0]}: {e}")

conn.commit()

except Error as e:

conn.rollback()

三、高并发环境下的特殊处理

当系统QPS超过500时,传统解决方案可能失效,需要采用分布式策略:

-

Twitter Snowflake算法实现

public class SnowflakeIdWorker { // 代码实现包含数据中心ID、机器ID、序列号等部分 public synchronized long nextId() { long timestamp = timeGen(); if (timestamp < lastTimestamp) { // 处理时钟回拨 } if (lastTimestamp == timestamp) { sequence = (sequence + 1) & sequenceMask; if (sequence == 0) { timestamp = tilNextMillis(lastTimestamp); } } else { sequence = 0L; } lastTimestamp = timestamp; return ((timestamp - twepoch) << timestampLeftShift) | (datacenterId << datacenterIdShift) | (workerId << workerIdShift) | sequence; } } -

数据库分段批量取号

-- 创建号段表 CREATE TABLE id_segment ( biz_tag VARCHAR(32) PRIMARY KEY, max_id BIGINT NOT NULL, step INT NOT NULL, update_time TIMESTAMP ); -- 获取号段 START TRANSACTION; SELECT max_id, step FROM id_segment WHERE biz_tag = 'order' FOR UPDATE; UPDATE id_segment SET max_id = max_id + step WHERE biz_tag = 'order'; COMMIT;

四、主键设计的最佳实践

-

自增主键的隐患

CREATE TABLE transactions ( id INT AUTO_INCREMENT PRIMARY KEY, order_id VARCHAR(20) UNIQUE ); -- 分库分表时自增ID会导致全局重复 -

复合主键设计规范

CREATE TABLE order_items ( order_id INT, item_seq INT, product_id INT, PRIMARY KEY (order_id, item_seq), UNIQUE (order_id, product_id) ); -

UUID优化方案

-- 使用有序UUID版本 CREATE TABLE users ( id BINARY(16) PRIMARY KEY DEFAULT (UUID_TO_BIN(UUID(), 1)), name VARCHAR(50) );

五、全链路防御体系构建

-

事前预防

- 数据库Schema审核工具(如Percona Toolkit)

- ORM配置校验(Hibernate示例):

<id name="id" type="long"> <column name="id" not-null="true" unique="true"/> <generator class="com.custom.CustomIDGenerator"/> </id>

-

事中监控

- 实时捕获1062错误日志

# Django中间件示例 class DuplicateKeyMiddleware: def __init__(self, get_response): self.get_response = get_response def __call__(self, request): response = self.get_response(request) if response.status_code == 500: if 'Duplicate entry' in response.content.decode(): # 触发告警并记录详细上下文 capture_exception() return response -

事后分析

- 使用pt-query-digest分析慢查询日志

- 可视化重复趋势(Grafana示例)

SELECT DATE_FORMAT(error_time, '%Y-%m-%d %H:00') AS hour, COUNT(*) AS errors, MAX(example_data) AS sample_data FROM error_logs WHERE error_code = 1062 GROUP BY hour;

六、云原生环境下的新挑战

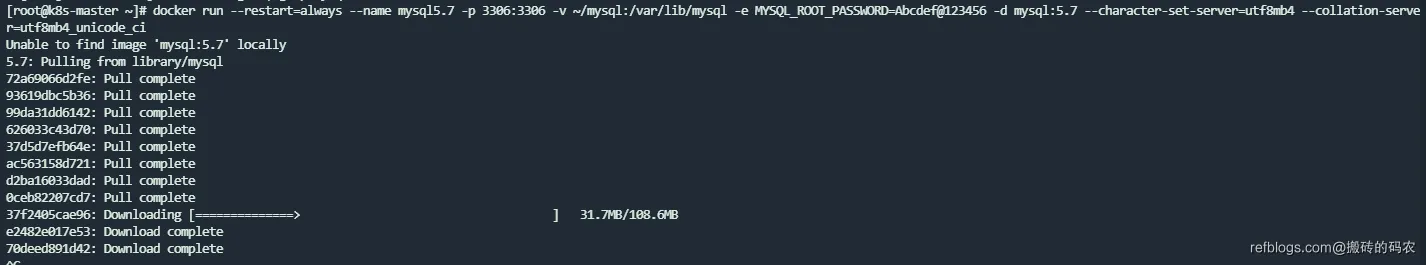

在Kubernetes集群中部署数据库时,主键冲突可能呈现新的特征:

-

StatefulSet的Pod重启

apiVersion: apps/v1 kind: StatefulSet spec: serviceName: "mysql" replicas: 3 template: spec: terminationGracePeriodSeconds: 10 containers: - name: mysql env: - name: MYSQL_ROOT_PASSWORD value: "password" args: - "--server-id=$$(hostname | sed 's/mysql-//')" - "--auto_increment_increment=3" - "--auto_increment_offset=$$(( $$(hostname | sed 's/mysql-//') + 1 ))" -

分布式序列服务对比

| 服务 | 吞吐量 | 延迟 | 一致性 | 运维复杂度 |

|---|---|---|---|---|

| MySQL AUTO_INCREMENT | 1万/s | 1ms | 强一致 | 低 |

| Redis INCR | 10万/s | 0.1ms | 最终 | 中 |

| ZooKeeper顺序节点 | 5千/s | 3ms | 强一致 | 高 |

| Snowflake | 100万/s | 0ms | 弱 | 低 |

七、前沿解决方案探索

-

AI预测分配算法

# 基于LSTM的ID需求预测 model = Sequential() model.add(LSTM(50, input_shape=(look_back, 1))) model.add(Dense(1)) model.compile(loss='mean_squared_error', optimizer='adam') model.fit(trainX, trainY, epochs=100, batch_size=1) -

量子加密主键生成

func generateQuantumID() string { qrand.Seed(time.Now().UnixNano()) id := make([]byte, 16) _, err := qrand.Read(id) if err != nil { panic(err) } return hex.EncodeToString(id) }

通过这个完整的解决方案体系,开发者可以从根本上理解主键冲突的成因,并针对不同场景选择最合适的处理策略。在系统设计的不同阶段采取相应的预防措施,结合先进的分布式ID生成方案,可以构建出健壮的数据库架构。

正文到此结束

相关文章

热门推荐

评论插件初始化中...